Generative KI ist eine spannende neue Technologie, die viele Unternehmen interessiert. Aber was genau ist das eigentlich? Lass uns zusammen herausfinden, was Generative KI kann und wie sie Firmen trotz aktueller Unsicherheit über die Technologie helfen kann. Die Technik hat das Potenzial, viele Abläufe in Unternehmen zu verbessern, neue Ideen zu entwickeln und Firmen einen Vorsprung und Wettbewerbsvorteil zu verschaffen.

Schlüsselpunkte

- Nur 38% fühlen sich gut auf KI-Schulungen vorbereitet

- 80% der Unternehmen entwickeln eine KI-Strategie

- Über 50% planen höhere KI-Investitionen

- 67% erwarten Umsatzsteigerungen durch KI

- 65% rechnen mit Kostensenkungen

Inhaltsverzeichnis

Definition – Was ist Generative KI?

Generative KI ist eine Art künstliche Intelligenz, die neue Inhalte erschaffen kann. Sie verwendet komplizierte Rechenmethoden und riesige Mengen an Daten, um Texte, Bilder, Videos und sogar 3D-Modelle zu erstellen. Stell dir vor, du hättest einen super kreativen Helfer, der dir bei allen möglichen Aufgaben zur Seite steht! Diese KI-Systeme können nicht nur vorhandene Informationen auswerten, sondern auch ganz neue und originelle Inhalte erzeugen, die es vorher noch nicht gab.

Die Technik hinter generativer KI basiert auf sogenannten neuronalen Netzwerken. Diese sind dem menschlichen Gehirn nachempfunden und lernen aus Beispielen. Je mehr Daten sie verarbeiten, desto besser werden ihre Ergebnisse. Diese neuronalen Netzwerke bestehen aus vielen miteinander verbundenen „Neuronen“, die Informationen verarbeiten und weitergeben. Durch das Training mit großen Datenmengen lernen diese Netzwerke, Muster zu erkennen und nachzuahmen. So können sie neue Inhalte erzeugen, die den Trainingsdaten ähneln, aber trotzdem einzigartig sind.

Wie funktioniert Generative KI?

Der Prozess lässt sich grob in drei Schritte unterteilen:

- Datenaufnahme und -verarbeitung

- Musteranalyse und -erkennung

- Generierung neuer Inhalte

Zuerst nimmt die KI riesige Mengen an Daten auf. Das können Texte, Bilder oder andere Informationen sein. Diese Daten werden sorgfältig aufbereitet und in ein für die KI verständliches Format gebracht. Dann analysiert sie diese Daten und erkennt Muster. Dabei werden komplexe statistische Methoden und Machine-Learning-Algorithmen eingesetzt, um Strukturen, Zusammenhänge und wiederkehrende Elemente in den Daten zu identifizieren. Zum Schluss nutzt sie dieses „Wissen“, um neue, einzigartige Inhalte zu erstellen. Dieser letzte Schritt ist besonders faszinierend, da die KI hier nicht einfach kopiert, sondern auf Basis des Gelernten völlig neue Kreationen erschafft.

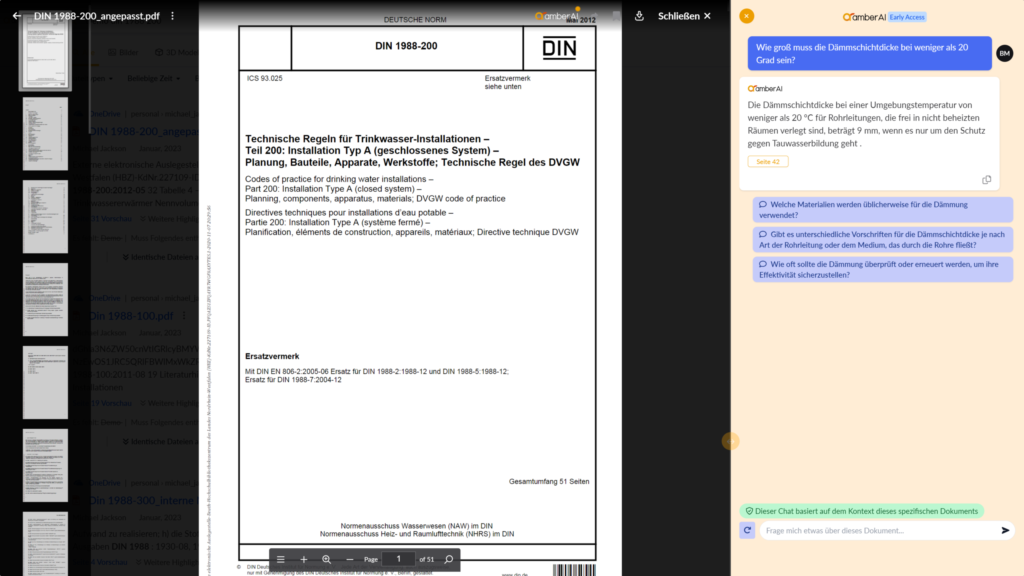

amberAI nutzt genau diese Technologie, um deine Unternehmensdaten intelligent zu verarbeiten und dir schnell die Informationen zu liefern, die du brauchst. Durch den Einsatz fortschrittlicher generativer KI-Modelle kann amberAI nicht nur Daten analysieren, sondern auch kontextbezogene Antworten generieren und komplexe Zusammenhänge in deinen Unternehmensdaten aufdecken.

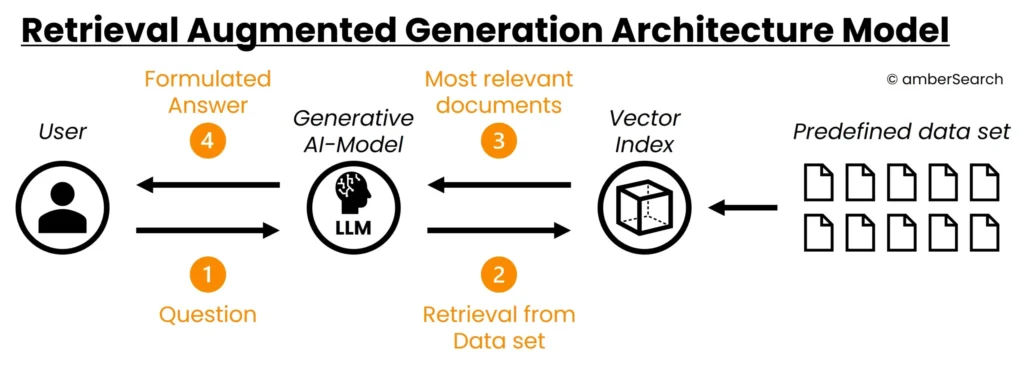

Um diese Prozesse noch effektiver zu gestalten, nutzen moderne KI-Systeme das sogenannte Retrieval Augmented Generation (RAG) System. Dieses System arbeitet in drei aufeinander aufbauenden Schritten:

Abbildung 7: Eine Erläuterung eines Retrieval Augmented Generations Modells ohne die Integration einer Enterprise Search.

Retrieval: Zunächst durchsucht das System die verfügbaren Datenquellen und identifiziert die relevantesten Informationen für die jeweilige Aufgabe.

Augmentation: Die gefundenen Informationen werden aufbereitet und mit zusätzlichem Kontext angereichert, um eine solide Grundlage für die Generierung zu schaffen.

Generation: Basierend auf den aufbereiteten Informationen erstellt die KI dann neue, maßgeschneiderte Inhalte.

Dieser RAG-Ansatz stellt sicher, dass die generierten Inhalte nicht nur kreativ, sondern auch faktenbasiert und relevant sind. Die Kombination aus Informationssuche und generativer KI ermöglicht so besonders präzise und verlässliche Ergebnisse.

Warum ist Generative KI so wichtig für Unternehmen?

Generative KI ist nicht nur ein cooler Technik-Trend. Sie bietet echte Vorteile für Unternehmen und hat das Potenzial, ganze Branchen zu revolutionieren:

- 1. Zeitersparnis: Sie übernimmt langweilige Routineaufgaben und gibt dir mehr Zeit für wichtige Dinge. Mitarbeiter können sich auf strategische und kreative Aufgaben konzentrieren, während die KI repetitive Arbeiten erledigt.

- 2. Kreativität: Sie liefert neue Ideen und Lösungsansätze, auf die du vielleicht nicht gekommen wärst. Generative KI kann als Ideengenerator dienen und frische Perspektiven in Brainstorming-Prozesse einbringen.

- 3. Effizienz: Sie kann riesige Datenmengen viel schneller verarbeiten als ein Mensch. Dies ermöglicht schnellere Entscheidungsfindungen und die Identifikation von Trends und Mustern, die sonst möglicherweise übersehen würden.

- 4. Personalisierung: Sie ermöglicht maßgeschneiderte Angebote und Kommunikation für deine Kunden. Durch die Analyse von Kundendaten kann generative KI hochindividualisierte Inhalte und Produktempfehlungen erstellen.

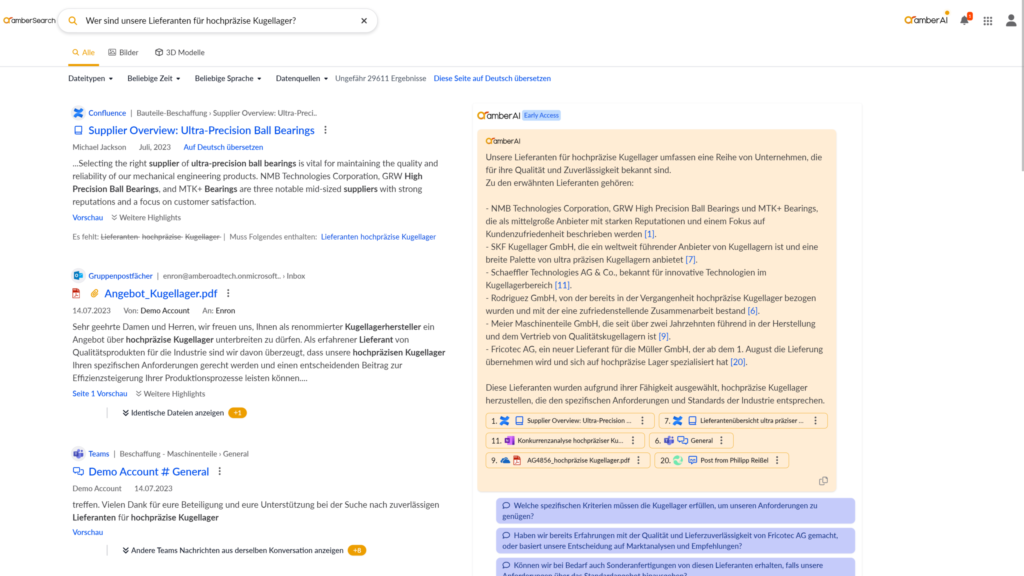

- 5. Dezentrale Informationsverarbeitung: In modernen Unternehmen liegen Informationen oft verstreut in verschiedenen Systemen, Datenbanken und Dokumenten vor. Generative KI kann diese verteilten Informationen intelligent verknüpfen und durchsuchen. Sie überwindet damit die traditionellen Silos zwischen Abteilungen und Systemen, macht Wissen unternehmensweit zugänglich und ermöglicht eine effizientere Nutzung aller verfügbaren Informationsressourcen. Dies spart nicht nur wertvolle Zeit bei der Informationssuche, sondern erschließt auch bisher verborgene Zusammenhänge und Erkenntnisse.

Abbildung 1: Der vorliegende Screenshot aus der Software amberSearch veranschaulicht die potenzielle Anwendung generativer KI auf unternehmensinternes Know-how

Unsere Enterprise Search Software nutzt generative KI, um genau diese Vorteile in dein Unternehmen zu bringen. Sie verbindet verschiedene Datenquellen, analysiert Informationen in Echtzeit und liefert maßgeschneiderte Erkenntnisse für jede Abteilung deines Unternehmens.

Anwendungsbeispiele für Generative KI

Die Möglichkeiten sind fast endlos. Hier ein paar Beispiele, wie Unternehmen generative KI einsetzen:

Kundenservice

Chatbots für Fragen und Probleme

Contenterstellung

Texte, Bilder und Videos für Marketing

Prozessoptimierung

Analyse von Daten zur Verbesserung

- Kundenservice: Chatbots, die Fragen beantworten und Probleme lösen. Diese KI-gestützten Assistenten können 24/7 verfügbar sein und komplexe Kundenanfragen bearbeiten, was zu einer erhöhten Kundenzufriedenheit und Effizienz führt.

- Content-Erstellung: Texte, Bilder und Videos für Marketing und Social Media. Generative KI kann Inhalte in verschiedenen Formaten und Stilen produzieren, was den Content-Erstellungsprozess beschleunigt und diversifiziert.

- Produktentwicklung: Neue Ideen und Designs generieren. KI kann innovative Produktkonzepte vorschlagen und sogar 3D-Modelle erstellen, was den Innovationsprozess beschleunigt.

- Datenanalyse: Große Datenmengen auswerten und Muster erkennen. Generative KI kann komplexe Datensätze analysieren und aussagekräftige Visualisierungen erstellen, die Entscheidungsträgern helfen, fundierte Entscheidungen zu treffen.

- Personalwesen: Bewerbungen sichten und Mitarbeiter schulen. KI kann bei der Vorauswahl von Bewerbern helfen und personalisierte Schulungsprogramme für Mitarbeiter erstellen.

Dich interessiert das Thema generative KI und du überlegst, KI in deinem Unternehmen einzusetzen? Dann solltest du jetzt unser 16-seitiges White Paper mit den Best Practices zu der Einführung von generativer KI im Unternehmen mit allen Insights lesen:

hbspt.forms.create({ region: „eu1“, portalId: „25062520“, formId: „7a7a4c89-71f9-4e28-a112-8aeb1cd7e7a9“ });Erfolgreiche Praxisbeispiele

Die praktische Anwendung von generativer KI zeigt sich bereits in verschiedenen Branchen. Zwei besonders interessante Beispiele verdeutlichen das Potenzial:

DB Regio: Der Mobilitätsdienstleister nutzt generative KI, um interne Prozesse zu optimieren. Mitarbeiter können schnell auf wichtige Informationen zugreifen und erhalten präzise Antworten auf ihre Fragen. Dies führt zu effizienteren Arbeitsabläufen und besserer Entscheidungsfindung im operativen Geschäft.

ENTECCOgroup: Das Technologieunternehmen setzt generative KI ein, um die unternehmensweite Informationssuche zu revolutionieren. Durch die intelligente Verarbeitung und Verknüpfung von Daten aus verschiedenen Quellen können Mitarbeiter relevante Informationen schneller finden und nutzen. Dies steigert die Produktivität und reduziert den Zeitaufwand für Recherchen erheblich.

Abbildung 2: Häufig müssen bei der Beantwortung von Fragen Informationen aus verschiedenen dezentralen Datensilos berücksichtigt werden. Der beigefügte Screenshot veranschaulicht, wie mithilfe einer LLM-basierten Suche interne Unternehmensinformationen gefunden werden können.

Diese Beispiele zeigen, dass generative KI nicht nur theoretische Möglichkeiten bietet, sondern bereits heute konkrete Verbesserungen in Unternehmen bewirkt. Die Technologie unterstützt dabei sowohl operative als auch strategische Prozesse und schafft messbaren Mehrwert für Mitarbeiter und Unternehmen.

Herausforderungen und Risiken

Natürlich ist generative KI kein Wundermittel. Es gibt auch Herausforderungen:

1. Datenschutz: Wie gehen wir mit sensiblen Informationen um? Die Verarbeitung großer Datenmengen durch KI-Systeme erfordert robuste Sicherheitsmaßnahmen und die Einhaltung strenger Datenschutzrichtlinien.

2. Qualitätskontrolle: KI-generierte Inhalte müssen überprüft werden. Es besteht die Gefahr von Fehlern oder Verzerrungen in den generierten Inhalten, was eine sorgfältige menschliche Überprüfung notwendig macht.

3. Ethische Fragen: Wie stellen wir faire und unvoreingenommene Ergebnisse sicher? KI-Systeme können unbeabsichtigt Vorurteile verstärken, was zu ethischen Problemen führen kann.

4. Mitarbeiterakzeptanz: Wie integrieren wir KI, ohne Ängste zu schüren? Die Einführung von KI-Technologien kann bei Mitarbeitern Befürchtungen um ihren Arbeitsplatz wecken, was eine sensible Kommunikation und Schulung erfordert.

Bei amberSearch legen wir großen Wert auf Datenschutz und Sicherheit. Unsere Lösungen sind so konzipiert, dass sie diese Herausforderungen berücksichtigen. Wir implementieren modernste Verschlüsselungstechnologien und Zugriffskontrollen, um die Integrität und Vertraulichkeit der Daten unserer Kunden zu gewährleisten.

Wie du Generative KI in dein Unternehmen bringst

Du willst generative KI nutzen? Hier ein paar Tipps für den Einstieg:

- Analysiere deinen Bedarf: Wo kann KI dir wirklich helfen? Führe eine gründliche Analyse deiner Geschäftsprozesse durch und identifiziere Bereiche, in denen generative KI den größten Mehrwert bieten kann.

- Fang klein an: Teste KI-Tools in einzelnen Abteilungen. Beginne mit Pilotprojekten in ausgewählten Bereichen, um Erfahrungen zu sammeln und den Wert der Technologie zu demonstrieren.

- Bilde deine Mitarbeiter: KI-Kompetenz ist der Schlüssel zum Erfolg. Investiere in umfassende Schulungsprogramme, um deine Mitarbeiter mit den Grundlagen der KI vertraut zu machen und ihre Fähigkeiten im Umgang mit KI-Tools zu verbessern.

- Setze auf Qualität: Wähle seriöse Anbieter und Tools. Recherchiere gründlich und entscheide dich für KI-Lösungen, die sich bereits in der Praxis bewährt haben und die Anforderungen deines Unternehmens erfüllen.

- Bleib flexibel: Die Technologie entwickelt sich schnell weiter. Sei bereit, deine KI-Strategie regelmäßig zu überprüfen und anzupassen, um von den neuesten Entwicklungen zu profitieren.

Unsere Enterprise Search Software ist ein guter Startpunkt, um generative KI in deinem Unternehmen zu nutzen. Sie bietet eine benutzerfreundliche Oberfläche und lässt sich nahtlos in bestehende Systeme integrieren, was den Einstieg in die Welt der generativen KI erleichtert.

Die Zukunft der Generativen KI

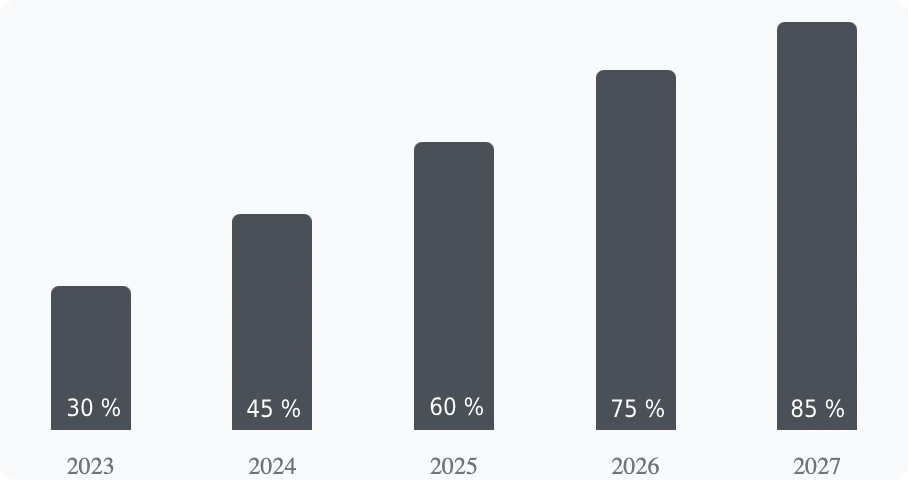

Generative KI entwickelt sich rasant weiter. Experten erwarten in den nächsten Jahren:

Prognose: Wachstum der Generativen KI-Nutzung

1. Noch präzisere und kontextbezogenere Ergebnisse: KI-Modelle werden immer besser darin, den Kontext zu verstehen und relevante Informationen zu liefern.

2. Bessere Integration in Alltagsanwendungen: Generative KI wird nahtlos in bestehende Softwarelösungen integriert, was ihre Nutzung vereinfacht.

3. Mehr Möglichkeiten für kreative Aufgaben: KI wird verstärkt in kreativen Bereichen wie Design und Produktentwicklung eingesetzt.

4. Stärkerer Fokus auf ethische KI-Entwicklung: Es wird mehr Wert auf Fairness, Transparenz und Verantwortung bei der Entwicklung von KI-Systemen gelegt.

Mit amberAI bleibst du immer auf dem neuesten Stand der Technologie. Wir arbeiten kontinuierlich daran, unsere KI-Modelle zu verbessern und neue Funktionen zu integrieren, die deinem Unternehmen einen Wettbewerbsvorteil verschaffen.

Fazit: Generative KI als Chance für dein Unternehmen

Generative KI ist eine spannende neue Technologie, die Unternehmen viele Vorteile bringen kann. Sie macht Arbeit effizienter, fördert Kreativität und kann zu mehr Erfolg führen. Es gibt zwar auch Herausforderungen, aber mit der richtigen Herangehensweise und den passenden Werkzeugen kannst du enorm davon profitieren. Generative KI kann dazu beitragen, dass Mitarbeiter produktiver arbeiten, Kunden besser betreut werden und sich neue Geschäftsmöglichkeiten eröffnen.

amberSearch bietet dir die Tools und das Know-how, um generative KI sinnvoll in deinem Unternehmen einzusetzen.

Damit jeder amberSearch einmal ausprobieren kann, haben wir in unserer Onlinedemo eine mittlere sechsstellige Anzahl an Dokumenten auf über 10 Systeme verteilt:

Lass uns gemeinsam die Zukunft gestalten! Unsere Experten stehen bereit, um dich bei der Integration von KI-Lösungen zu unterstützen und dein Unternehmen fit für die Zukunft zu machen.

Du findest unseren Content spannend?

Dann bleib jetzt über unseren Newsletter mit uns in Kontakt:

hbspt.forms.create({ region: „eu1“, portalId: „25062520“, formId: „16e3c416-5a9d-44fb-b451-d9f44c677475“ });