Wer kennt es nicht – Man sucht mal eben eine Information und findet alleine natürlich nichts in den unternehmensinternen Systemen. Daher fängt man an, die Kollegen um Hilfe zu fragen. Hat man dann das richtige Dokument gefunden, dauert es noch eine Ewigkeit, bis man darauf aufbauend eine Mail, etc. geschrieben hat. Schon heute verbringen Mitarbeiter 25 Minuten täglich mit der digitalen Suche – ein Wert, der um 77% in den letzten Jahren gestiegen ist. Diese Herausforderungen können hervorragend durch eine KI Suche gelöst werden.

Inhaltsverzeichnis

Was ist eine KI-Suche?

Eine KI-Suche nutzt speziell Technologien aus dem Bereich der Künstlichen Intelligenz, insbesondere des Natural Language Processing, um unternehmensinterne Daten effizient zugänglich zu machen. Diese Suchtechnologie optimiert die Suche nach Informationen durch intelligente Verarbeitung natürlicher Sprache.

In diesem Blogbeitrag geht es insbesondere um die unternehmensinterne Suche, im Fachjargon auch Enterprise Search genannt. Eine alternative Anwendung der KI-Suche wäre zum Beispiel der Einsatz im Web, wie man ihn von Internetsuchmaschinen wie Google, Bing oder Ecosia kennt.

Bei einer KI-Suche kommt es dabei insbesondere darauf an, dass das unternehmensinterne Know-How – unter Berücksichtigung etwaiger Zugriffsrechte und Regularien wie bspw. der DSGVO & Co – schnell und einfach zugänglich gemacht wird.

Aus technischer Sicht gibt es 3 Hauptverfahren, die bei der internen Suche genutzt werden:

- Die Federated Search, welche die Suchschnittstellen anderer Systeme ansteuert

- Die Keywordbasierte Suche, welche oftmals durch bestimmte NLP-Techniken ergänzt wird, jedoch nicht wirklich „intelligent“ ist

- Die intelligente bzw. LLM-basierte Suche, welche auf semantischer Basis nach Informationen sucht

KI-Suche in Kombination mit generativer KI

Der Wunsch vieler Unternehmen aktuell ist es, mit dem unternehmensinternem Know-How zu chatten. Aus technischer Sicht gibt es drei primäre technische Möglichkeiten, um mit internem Know-How zu chatten:

- Training eines eigenen KI-Modells

- Aufbau eines Retrieval Augmented Generation Modells

- Kombination einer KI-Suche mit Retrieval Augmented Generation

Die verschiedenen Vor-/Nachteile haben wir bereits in diesem Blogartikel diskutiert. Die technisch beste Antwort auf die Frage, ob man interne Inhalte besser über eine KI-Suche oder über einen KI-Chatbot ist keine entweder oder Frage. Idealerweise kombiniert man beide Systeme, um die jeweiligen Schwächen der einen bzw. anderen Technologie zu kombinieren.

So kann die KI-Suche Dinge wie Zugriffsrechte, Retrieval der relevanten Informationen aus den diversen Datensilos und Indizierung übernehmen, während der KI-Chatbot die ideale „Delivery“ an den Nutzenden sicherstellt und die Informationen in der Form aufbereitet, wie der Mitarbeiter diese benötigt.

Mehrwerte einer KI-Suche

Bevor man über die Mehrwerte einer KI-Suche spricht, sollte man sich über die Schmerzpunkte bewusst werden.

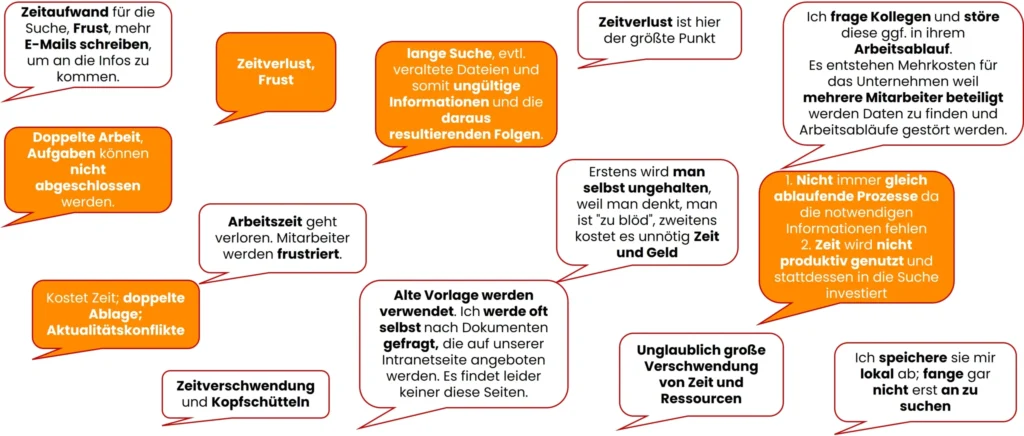

Dafür haben wir in einem mittelständischen Unternehmen mit 400 Mitarbeitern eine Umfrage durchgeführt und diverse Themen abgefragt. Eine der Frage war zum Beispiel, was die Konsequenzen einer schlechten Suche sind. Dies waren einige der Antworten:

Antworten aus unser Studie: Wie gut Finden Mitarbeitende unternehmensinterne Informationen?

Was sich ganz klar zeigt: Den Mitarbeitenden ist sehr bewusst, wie hoch die Kosten für das Unternehmen sind. Zusätzlich führen Informationen, die schlecht zugänglich sind, nicht nur zu schlecht umgesetzten Digitalprozessen bzw. Doppelarbeit, sondern vor allen Dingen zu Frust auf Mitarbeiterseite. Gerade in Zeiten von Fachkräftemangel und steigenden Erwartungen von Mitarbeitenden an die unternehmensinternen Softwaresystemen, ist dies ein schlechter Grund, um potenzielle Mitarbeitende zu verlieren.

Du möchtest alle Ergebnisse der Umfrage haben? Dann lade dir jetzt unser White Paper mit allen Ergebnissen der Studie herunter:

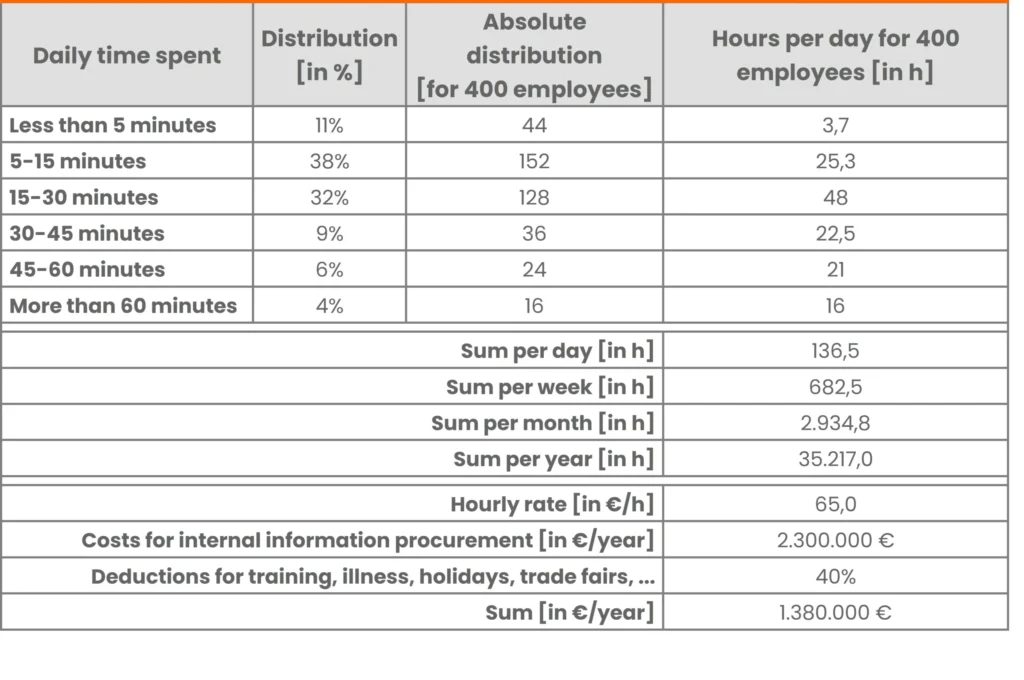

Bei einem Unternehmen mit 400 Mitarbeitenden können durch schlecht zugängliche Informationen schnell Kosten von über 1.400.000 € pro Jahr auflaufen.

Diese Grafik stamm aus dem Blogartikel Suchst du noch oder Findest du schon

Durch eine KI-Suche kann die digitale Suchzeit um bis zu 40% reduziert werden, wie wir bei diversen Kunden zeigen konnten. Dementsprechend können alleine bei der Suchzeit der Mitarbeitenden 550.000 € gespart werden. In Kombination mit der generativen KI können zusätzlich Mehrwerte durch die deutlich schnellere Bereitstellung von aus- bzw. umformulierten Texten ergeben. Dafür gibt es im Unternehmen diverse Anwendungsfälle, die wir auf unserem YouTube-Channel näher beleuchten.

Ein weiterer Mehrwert ist, dass die Zufriedenheit der Mitarbeitenden mit den internen IT-Systemen deutlich steigt. Des Weiteren steigt die Kollaboration in den verschiedenen Teams, da relevante Informationen viel besser gefunden werden können.

Damit jeder amberSearch einmal ausprobieren kann, haben wir in unserer Onlinedemo eine mittlere sechsstellige Anzahl an Dokumenten auf über 10 Systeme verteilt:

Integration einer KI-Suche in bestehende Systeme

Wer eine KI-Suche implementiert, sollte 2 Dinge bedenken:

- Welche Systeme soll die KI-Suche durchsuchen können?

Im Normalfall wird bei Standardsystemen mit Standardkonnektoren gearbeitet, welche in der Lage sind, bestehende Zugriffsrechte zuverlässig zu berücksichtigen. Einige Systeme wie amberSearch haben eine Schnittstelle, mit der auch individuelle Systeme angebunden werden können.

- Wie soll die Software dem Nutzenden zur Verfügung gestellt werden?

Durch B2C-Apps wie Instagram, Facebook und Co haben Nutzende heutzutage eine sehr hohe Software an die Nutzererfahrung von Unternehmenssoftwarelösungen. Darum ist darauf zu achten, dass eine Software dem Nutzenden dort zur Verfügung gestellt wird, wo der Mitarbeitende täglich arbeitet. Dies kann bedeuten, dass die Software per Teamsapp, Webapp, Desktopapp oder u. A. auch mobil bzw. per Chrome Plug-In verfügbar sein muss – alles Möglichkeiten, die amberSearch anbietet.

Eine komplette Übersicht der Integrationen ist hier zu finden.

Aufwände bei der Implementation einer KI-Suche

Eine Frage, die sich schnell stellt, ist die Suche nach dem Hosting der Software. Typischerweise müssen gerade LLM-basierte Suchen als Managed Service gehostet werden. Da LLM’s recht hohe Hardwareanforderungen haben, sind diese für KMU’s nur selten realisierbar. Der Vorteil ist jedoch, dass eine Managed Service Lösung mit einem technischen Aufwand von 4 Stunden implementiert werden kann.

Übrigens: Als einer von wenigen Anbietern hat amberSearch volle Ownership über die KI-Modelle und wäre daher bei Bereitstellung von ausreichend Hardware in der Lage, auch eine LLM-basierte Suche On Premise zu hosten.

Du findest unseren Content spannend?

Dann bleib jetzt über unseren Newsletter mit uns in Kontakt: