Jeder möchte generative KI im Unternehmen einsetzen, doch nur wenige haben ein Gefühl für die notwendige Wertschöpfungskette, um die Aufwände und Kosten realistisch einschätzen zu können. In diesem Artikel soll es weniger um die konkrete Einführung von generativer KI gehen -dazu haben wir bereits diverse Artikel geschrieben. Viel mehr soll es um die technische Infrastruktur im Hintergrund gehen – generative KI Tech-Stack.

Inhaltsverzeichnis

Definition generative KI Tech-Stack

Ein generative KI Tech-Stack umfasst alle Ressourcen und Elemente, die notwendig sind, um Mitarbeitenden und Unternehmen KI-Lösungen anzubieten.

Um generative KI im Unternehmen sinnvoll einsetzen zu können, sind eine Reihe von Ressourcen notwendig. Die Hauptressourcen dafür sind die folgenden:

- Hardwareressourcen zum Training und Betreiben der KI-Modelle

- Die KI-Modelle selbst

- KI-Applikationen, die die KI nutzbar machen

Selbstverständlich könnte man diese Liste erweitern: Um Chips, die natürlich Teil der Hardwareressourcen sind, um Trainingsdaten, die benötigt werden, um die KI-Modelle zu trainieren usw. Jedoch soll dieser Artikel helfen, Unternehmen, die KI anwenden, aber kein tiefgehendes Wissen haben, ein Verständnis für die notwendige Infrastruktur aufzubauen.

Hardwareressourcen

Software benötigt Hardware in Form von Servern, um betrieben zu werden. Das dies gerade bei großen Sprachmodellen (Large Language Modellen, LLM‘s) der Fall ist, wissen alle seit dem der Aktienkurs von NVIDIA durch die Decke gegangen ist.

Einerseits sind Hardwareressourcen wichtig, um die KI-Modelle initial zu trainieren. Auch wenn nicht zu hundert Prozent klar ist, wie teuer das Training eines KI-Modells ist, so vermutet man, dass aktuelle LLM’s jenseits der 100 Milliionen Dollar Grenze liegen.

Andererseits werden die Hardwareressourcen benötigt, um die KI-Modelle zu betreiben. Der ressourcenintensive Teil ist dabei vor allen Dingen die Vektorisierung der Informationen. Dies ist notwendig, damit die Daten für KI-Modelle „lesbar“ werden.

KI-Modelle

KI-Modelle an sich sind bloß eine Technologie. Grundsätzlich gibt es verschiedene Arten von KI-Modellen, doch Stand 2024 versteht die breite Masse unter KI vor allen Dingen Applikationen in Bezug auf LLM’s. Darum liegt der Fokus dieses Artikels ausschließlich auf dieser Art von KI.

Es gibt 2 Arten, über die man an KI-Modelle kommen kann: Open Source Modelle stehen zum freien Download zur Verfügung, während Closed Source Modelle vom Hersteller betrieben werden und über API-Calls genutzt werden können.

KI-Applikationen

KI-Modelle sind bloß eine Technologie und eine Technologie ohne Anwendungsfall löst keine Probleme. Um KI-Modelle sinnvoll einsetzen zu können, bedarf es jedoch spezifischer Herausforderungen, bei denen KI den besten Lösungsansatz darstellt. Eine Applikationsart, bei der KI die technisch beste Lösungsmethode ist, ist zum Beispiel eine Enterprise Search. Eine Enterprise Search hilft Mitarbeitenden, dass interne Wissen im Unternehmen schnell und einfach zugänglich zu machen.

Applikationen bilden also die Schnittstelle zwischen KI-Modelle und Nutzer und machen die Technologie „nutzbar“.

Damit jeder amberSearch einmal ausprobieren kann, haben wir in unserer Onlinedemo eine mittlere sechsstellige Anzahl an Dokumenten auf über 10 Systeme verteilt:

Integration von KI im Unternehmen

Für viele Unternehmen ist eine Integration der eigenen Daten in ein KI-Modell sehr wichtig, um ihr eigenes Wissensmanagement durch KI zu verbessern. Es gibt verschiedene Arten, über die man KI im Unternehmen einsetzen kann – zum Beispiel integrierte KI-Lösungen, KI-Assistenten oder in Form von KI-Agenten. Diese sind ausführlicher in diesem Blogartikel erklärt.

Eine Frage, die dabei immer wieder aufkommt, ist die Frage, ob Informationen in der Cloud oder On Premise gehostet werden sollen. Im Allgemeinen haben existiert hierzu bereits ein Blogartikel, der auch die Option einer Private Cloud beleuchtet.

Dennoch sollten – gerade mittelständische – Unternehmen, die über einen Einsatz von KI nachdenken, berücksichtigen, dass extrem viele Hardwareressourcen notwendig sind, um KI-Modelle selbst zu hosten. Über eine Cloudlösung sind diese Kosten deutlich besser abbildbar – ohne, dass der Business Case kaputt geht.

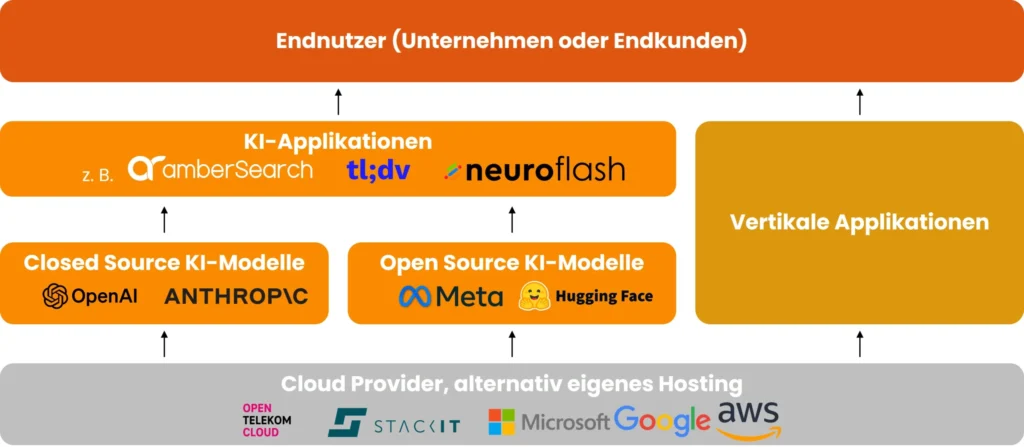

Visualisierung des generative KI Tech-Stacks

Nimmt man die bisherigen Erkenntnisse und visualisiert sie, dann würde eine Grafik ähnlich zu dieser herauskommen:

Überblick der Generativen KI-Wertschöpfungskette

Eine Art von Lösungen, über die wir bisher noch nicht gesprochen haben, sind vertikale Applikationen. So bietet zum Beispiel OpenAI eine vertikale Applikation an – einerseits im Hintergrund das KI-Modell (z. B. GPT 4o) sowie die Applikation selbst mit ChatGPT. Damit ist OpenAI in der Lage, direkt mehrere Schritte der Wertschöpfungskette abzubilden.

Best Practices der Implementierung eines generative KI Tech-Stacks

Gerade für mittelständische Unternehmen ist eine Implementierung als On Premise oder Private Cloud Lösung nicht zu empfehlen. Oftmals fehlt das Wissen zur Betreuung und Wartung dieser anspruchsvollen Ressourcen. In Zeiten des demografischen Wandels spricht nicht nur der Fachkräftemangel für einen Einsatz als Cloud Lösung, sondern auch der Business Case.

Wie die konkrete Implementierung aussieht, hängt stark vom Anwendungsfall bzw. der gewählten Lösung ab. Dennoch haben wir in diesem Blogartikel einen Überblick über die Basics einer KI-Integration geschaffen. Ergänzend können interessierte sich unsere Checkliste zur KI-Einführung bzw. die technischen Grundlagen einer KI-Einführung ansehen.

Fazit zum generative KI Tech-Stack

Der generative KI Tech-Stack im Unternehmen ist deutlich ressourcenintensiver als übliche Softwarelösungen. Der generative KI Tech-Stack im Unternehmen ist deutlich ressourcenintensiver als übliche Softwarelösungen. Die Einführung und der Betrieb generativer KI erfordern eine durchdachte Infrastruktur, die sowohl Hardwareressourcen als auch spezialisierte Software umfasst. Unternehmen, insbesondere mittelständische, sollten sich der erheblichen Investitionen bewusst sein, die für das Training und den Betrieb von KI-Modellen notwendig sind.

Die Entscheidung für Cloud-Lösungen kann in vielen Fällen die geeignete Wahl sein, da sie nicht nur die Kosten für Hardware und Wartung optimieren, sondern auch den Zugang zu hochentwickelter Technologie ermöglichen, ohne dass tiefgehendes internes Know-how erforderlich ist.

Du möchtest mehr erfahren?

Dann erstelle jetzt eine Kontaktanfrage: