Das KI das Geschäftsleben nachhaltig beeinflussen wird, ist in den Unternehmen mittlerweile angekommen. Doch so schnell wie die Technologie kam, fehlt oftmals das Know-How und das Verständnis für die Technologie, um realistische Erwartungen setzen zu können. Dieser Blogartikel gibt einen Einblick, wie generative KI üblicherweise in Unternehmen eingesetzt wird.

Inhaltsverzeichnis

Bevor es technischer wird, sollte man folgendes verstehen: Software ist immer nur Mittel zum Zweck und muss ein Businessproblem lösen. KI sollte auch nicht eingesetzt werden, nur weil es gerade im Trend liegt, sondern weil die Mehrwerte glasklar sind und technisch nicht besser gelöst werden können. Sollte es technisch andere, gleichwertige Lösungen geben, dann sind auch diese vollkommen legitim. Um die Technologie für den eigenen Anwendungsfall zu beurteilen, sollte man grob verstehen, wie eine generative KI funktioniert. Das hier vorgestellt KI-System ist für die meisten Anwendungsfälle aus technischer Sicht die beste Lösung, was jedoch nicht gilt, dass für bestimmte Anwendungsfälle andere Lösungen besser sind.

Wie kombiniert man generative KI mit unternehmensinternen Daten

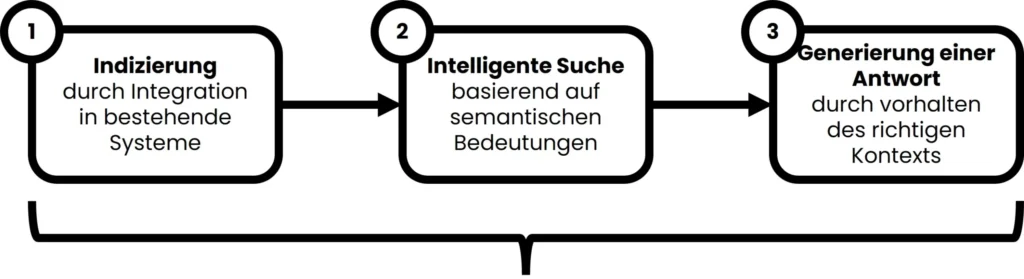

Die potenziellen Mehrwerte und Anwendungsfälle generativer KI sind für die meisten Unternehmen mittlerweile bekannt. Dennoch kann man nicht einfach ein KI-Modell mit den eigenen Daten trainieren, da dann Zugriffsrechte verloren gehen, neue Informationen nicht mehr berücksichtigt werden und durch das Training viele Hardwareressourcen und technisches Know-How benötigt werden (für weitere Informationen s. Blogbeitrag). Zusätzlich würde ein eigenes KI-Modell auch anfangen zu halluzinieren, was im Unternehmenskontext ein No-Go ist. Darum setzt man heutzutage auf Retrieval Augmented Generation (RAG), welches an verschiedenen Stellen verschiedene KI-Modelle einsetzt. Der Prozess sieht dazu sieht folgendermaßen aus:

Grober Ablauf eines Retrieval Augmented Generation Systems (inkl. Multi-Hop Q&A)

Um eine generative KI mit unternehmensinternen Daten zu kombinieren, muss zunächst ein Index (1) erstellt werden, in dem die Inhalte des Unternehmens in ein Embedding gebracht werden. Darauf wird eine intelligente Suche (2) aufgebaut und auf diesen Ergebnissen kann dann eine Antwort generiert werden (3). In den folgenden Absätzen wird näher auf die Technik und die Hintergründe eingegangen.

So funktionieren generative KI-Modelle

Mit Hilfe eines großen Datensatzes (aus dem Internet) werden generative KI-Modelle trainiert. Dadurch bauen sie zu allen Themen Wissen auf. Technisch gesehen, werden die Informationen in einem n-dimensionalen Raum (Vektorindex) als sogenannte Embeddings abgelegt. In diesem Raum sind die Inhalte insbesondere nach semantischer Relevanz „geclustert“, d. h. Informationen wie „Wie viel Geld hat “, „Wie viel Wohlstand hat“, „Wie reich ist“ sind semantisch gleichzusetzen und sind dementsprechend sehr nah aneinander angesiedelt. Stellt ein Nutzer nun einen Prompt, kommt es nicht so sehr darauf an, welches Wording genutzt wird, sondern auf die semantische Bedeutung. Daraus kann dann mit Hilfe mathematischer Algorithmen geschlossen werden, was weitere relevante Informationen sind. Die Antwort wird anschließend Wort für Wort, basierend auf einer mathematischen Wahrscheinlichkeit berechnet.

Für den individuellen Menschen wirken generative KI-Modelle sehr intelligent, da sie deutlich mehr Wissen haben, als es der individuelle Mensch hat. Dennoch geben Sie nur wieder, was sie einmal gelernt haben. Eine Challenge von generativen KI-Modellen ist, dass Sie anfangen zu halluzinieren, weil sie selbst durch die großen „Datenmengen“ durcheinanderkommen können und unter Umständen Informationen falsch kombinieren.

Damit jeder amberSearch einmal ausprobieren kann, haben wir in unserer Onlinedemo eine mittlere sechsstellige Anzahl an Dokumenten auf über 10 Systeme verteilt:

Retrieval Augmented Generation zur Vermeidung von Halluzinationen

Retrieval Augmented Generation hat den Vorteil, dass keine unternehmensspezifischen KI-Modelle trainiert werden müssen, da vor allen Dingen kontextbasiert gearbeitet wird. Die Grundlage für ein RAG-System ist die intelligente Suche. Die durch die intelligente Suche werden zunächst für den Nutzer relevante und zugängliche (also unter Berücksichtigung von Zugriffsrechten) Ergebnisse geliefert, die mit Hilfe einer KI (basierend auf den semantischen Inhalten) bewertet und geranked werden. Darauf aufbauend wird nun eine generative KI gesetzt. Dabei wird an das generative KI-Modell ein Prompt gegeben, der simpel beschrieben folgendermaßen aussieht: „Die Frage des Nutzers lautet „XXX?“ und die relevanten Ergebnisse sind „Ergebnis 1“, „Ergebnis 2“, „…“. Beantworte auf Basis dieses Kontextes die Frage des Nutzers.“ Nun wird also die allgemeine Intelligenz des generativen KI-Modells genutzt, um die als Kontext übergegeben Ergebnisse neuzuformulieren, anstatt die Frage aus dem Wissen des KI-Modells zu beantworten. Dadurch wird die Halluzinationen-Problematik entsprechend vermieden. Zusätzlich können durch die Bestimmung des Kontextes durch die vorgeschaltete Suche Zugriff aktuelle Dokumente und bspw. Zugriffsrechte berücksichtigt werden.

Eine intelligente Suche ist IMMER die Grundlage

In einem RAG-System spielt die intelligente Suche eine elementare Rolle. Sinnvollerweise setzt man hier auf eine moderne Enterprise Search bzw. auf ein generatives KI-System, welches eine solche Funktion beinhaltet (bspw. amberAI). Wenn die Suche schlechte Ergebnisse liefert, dann wird auch die generierte Antwort schlecht werden (Stichwort: Shit-In, Shit-Out). Bei amberSearch haben wir daher schon 2020 angefangen, intelligente Reranking-Modelle (basierend auf LLM’s) zu trainieren und zu veröffentlichten. Eines unserer erfolgreichsten Modelle hat mittlerweile eine mittlere sechsstellige Anzahl an Downloads erreicht und wurde von mehreren unabhängigen wissenschaftlichen Arbeiten als eines der effizientesten seiner Art bewertet.

Dieser Blogbeitrag ist Teil unseres White Papers „So geht eine erfolgreiche Einführung von generativer KI“. Wer das gesamte, 16-seitige White Paper mit allen Insights lesen möchte, der kann sich den ganzen Report hier kostenlos herunterladen:

Multi-Hop Question Answering als nächste Ausbaustufe

Die nächste Ausbaustufe von Retrieval Augmented Generation ist Multi-Hop Question Answering. In einem Standard RAG-System wird nämlich eine Suche formuliert, die sich dann primär auf ein Thema fokussieren kann. Wenn man jedoch probiert, Aufgaben wie „Schreibe mir eine Kaltakquisee-mail an unsere Buyerpersona Entwicklungsleiter vor und nenne unsere USP’s.“, dann wird ein Standard RAG-System schnell an die Grenzen stoßen. Um diese Frage zu beantworten, sind Informationen aus verschiedenen Quellen notwendig. Daher wird eine solche Anfrage folgendermaßen aufgebrochen:

- Vorlage Kaltakquise E-mail

- Buyerpersona Entwicklungsleiter

- Unsere USP’s

Ein Multi-Hop System findet zunächst zu jedem Schritt eine Antwort und verarbeitet diese dann in einer abschließenden Antwort. Somit sind deutlich fortschrittlichere und qualitativ bessere Antworten möglich, als wenn der Fokus nur auf einem dieser Themen läge. Wer ein zukunftsfähiges generatives KI-Tool im Unternehmen einsetzen möchte, der sollte sicherstellen, dass auch solche Funktionen in der Software verbaut sind.

KI-Agenten

Wo bei einem Multi-Hop Question Answering System in einem Schritt entschieden wird, wie die verschiedenen Schritte aussehen, so sind KI-Agenten in der Lage, Ergebnisse selbstständig zu überprüfen und mehrere Schritte auch mehrmals hintereinander auszuführen. In der Entwicklung sind zumindest autonome KI-Agenten deutlich komplexer, weshalb sie aktuell nur für verhältnismäßig einfache oder sehr häufig verbreitete Anwendungsfälle eingesetzt werden. Wir haben hier einen ausführlichen Blogartikel über KI-Agenten geschrieben.

Fazit

Die Unterschiede solcher Systeme liegen im Detail und man sollte verstehen, wo die technischen Unterschiede (und daraus resultierenden Einschränkungen) bei verschiedenen Anbietern liegen. In unserem Blogbeitrag Einführung von generativer KI sind wir auf verschiedene Anforderungen eingegangen, die Unternehmen haben (sollten), wenn sie selbst eine generative KI einsetzen möchten.

Du findest unseren Content spannend?

Dann bleib jetzt über unseren Newsletter mit uns in Kontakt: