Generative KI wird zukünftig aus unserem Alltag nicht mehr wegzudenken sein und schon heute beschäftigen Unternehmen sich damit, wie sie generative KI nachhaltig im Unternehmen einsetzen können. Der einfachste Anwendungsfall von generativer KI im Unternehmen ist ein klassischer Assistent, der einem Mitarbeiter hilft, internes Know-How schneller und besser zu verarbeiten. Bei dem Hype, der aktuell herrscht will bzw. muss jedes Unternehmen dabei sein. Doch wie kann man ein internes KI-basiertes Assistenzsystem möglichst effizient einsetzen?

Inhaltsverzeichnis

Der Status quo für übergreifende, KI-basierte Assistenzsysteme

Diverse CRM-, Archivsystem- oder Intranetanbieter entwickeln zurzeit eigene Copiloten bzw. Assistenzsysteme, um die diversen Anwendungsfälle von generativer KI im Unternehmen abzudecken – so natürlich auch Microsoft, doch dazu später mehr. Für die Kunden eine vermeintlich einfache Lösung, um generative KI einzuführen. Es gibt jedoch einen Haken dabei:

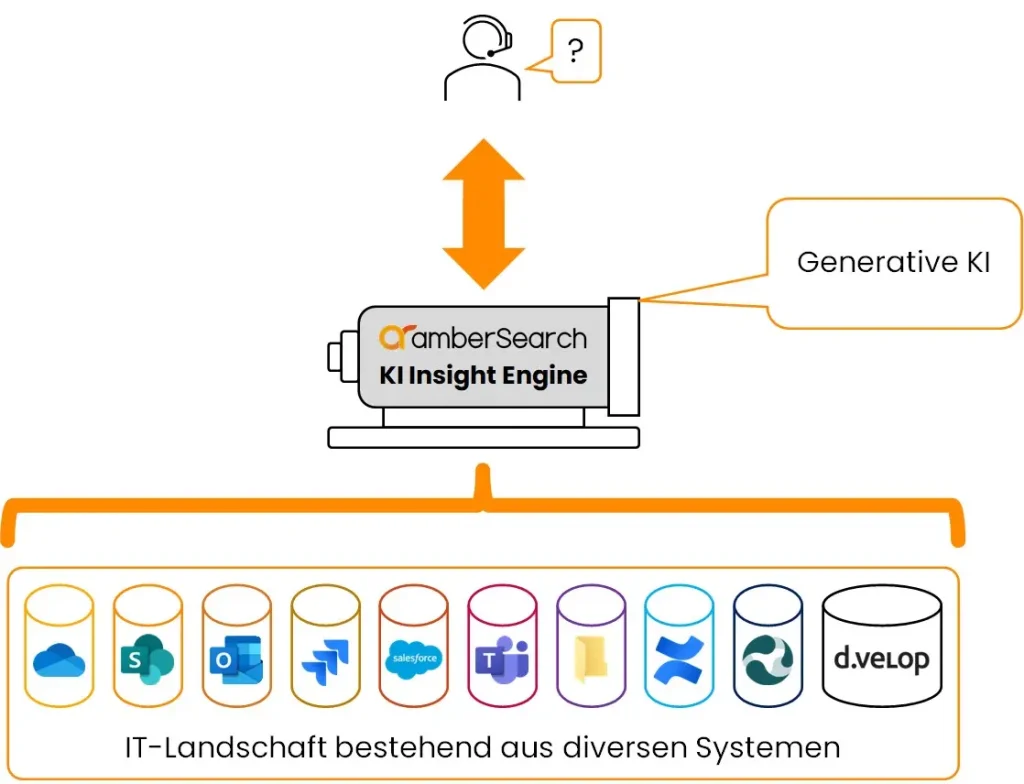

Unternehmen nutzen diverse IT-Systeme und bisher unterstützt das Assistenzsystem (bzw. Copilot, Buddy, Sekretär, etc) nur das Softwareökosystem des jeweiligen Anbieters. Und aus technischer Sicht wird sich dies auch nicht ändern, da klassische Softwareanbieter nicht genug Ressourcen haben werden, um ein systemübergreifendes Assistenzsystem zu unterstützen. Für den Kunden bedeutet das, dass sie sich für ein System entscheiden müssen oder teuer für jedes einzelne Tool das jeweilige KI-basierte Assistenzsystem (falls vorhanden) kaufen muss. Auf lange Sicht ist dies einerseits teuer, andererseits frustrierend für den Mitarbeiter, da er nie einen wirklich übergreifenden Zugriff haben wird, sondern stets in dem Ökosystem eines spezifischen Anbieters begrenzt bleibt. Daher macht es für Unternehmen Sinn, die vorhandenen Ressourcen zu bündeln und in ein übergreifendes, KI-basiertes Assistenzsystem zu investieren. Probiert man jedoch, alle Informationen in einem Ökosystem zu bündeln und auch noch das KI-basierte Assistenzsystems des Anbieters zu nutzen, steigt wiederum der Vendor Lock-In.

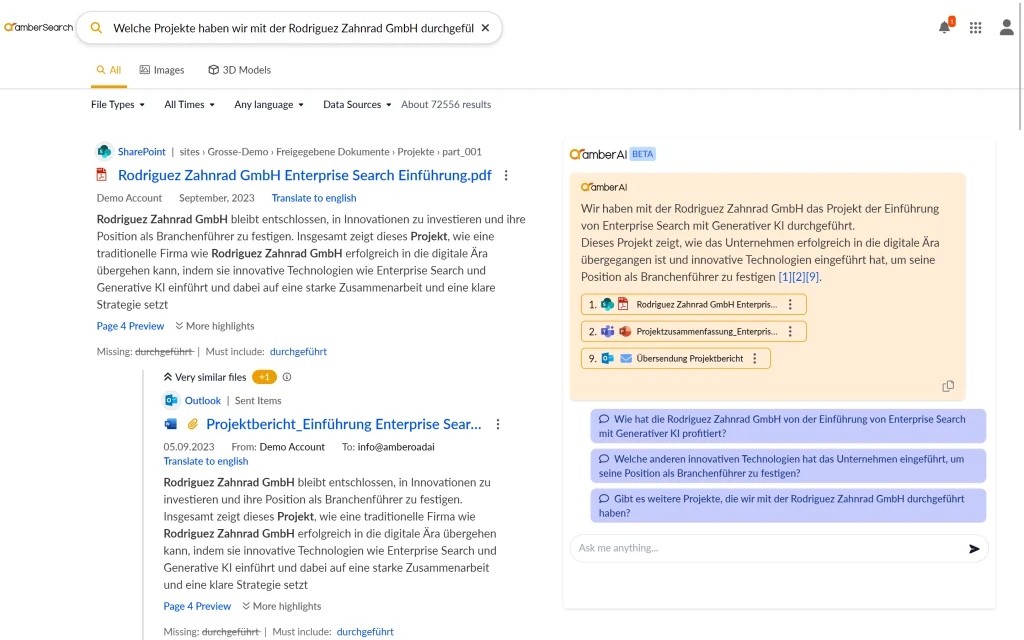

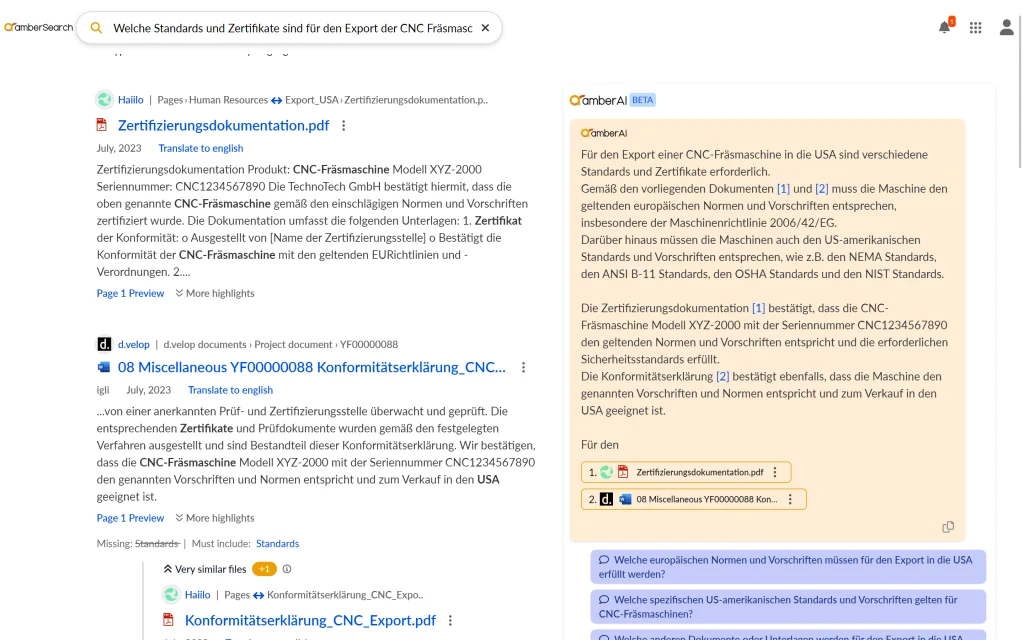

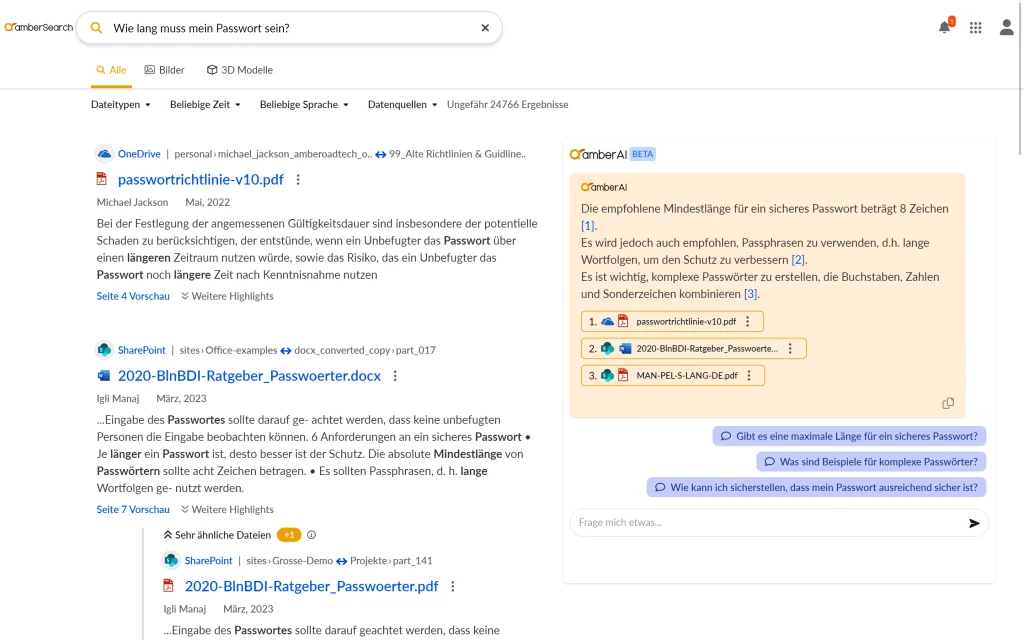

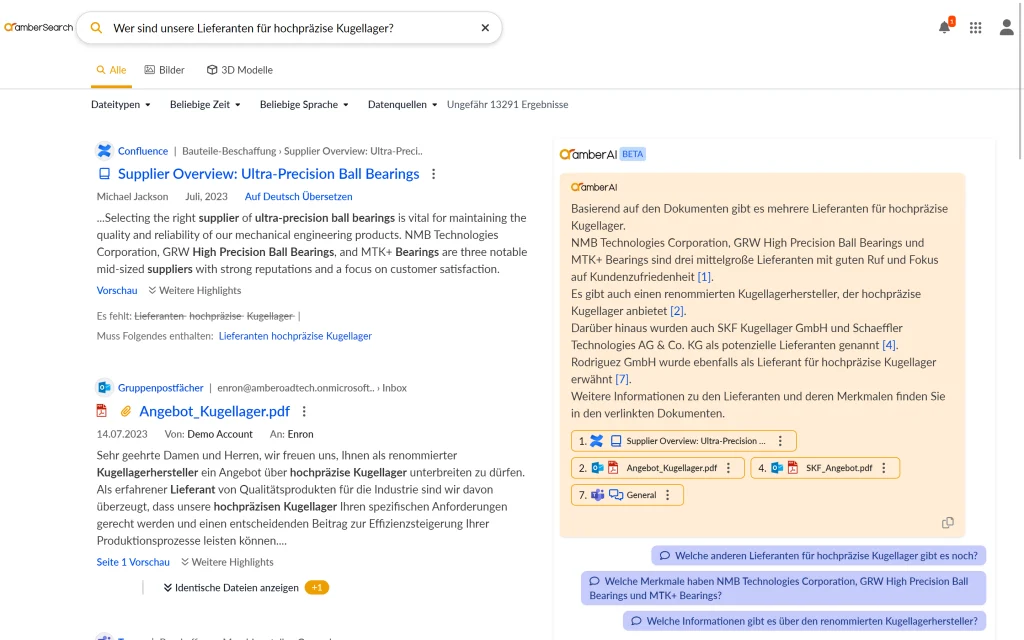

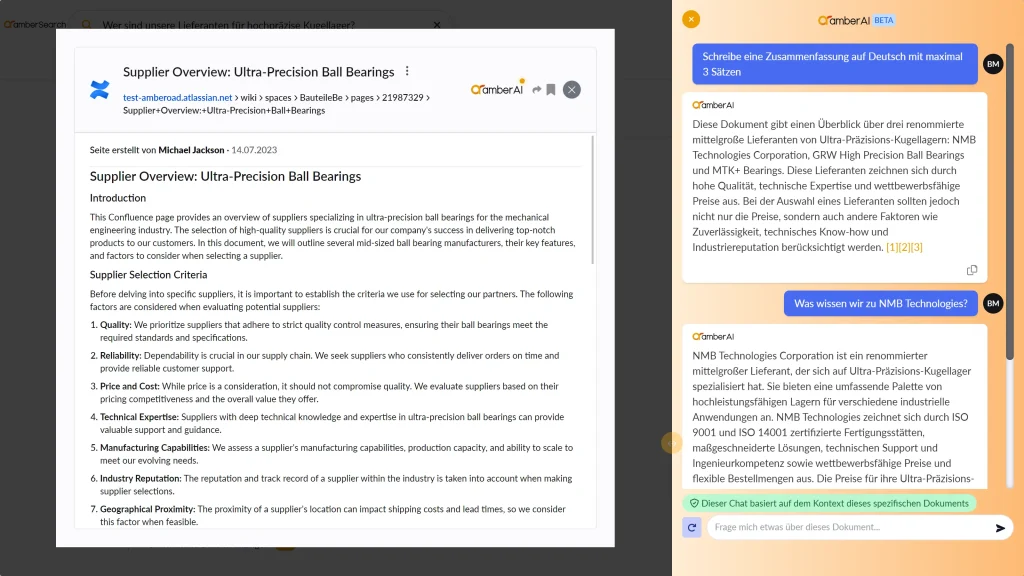

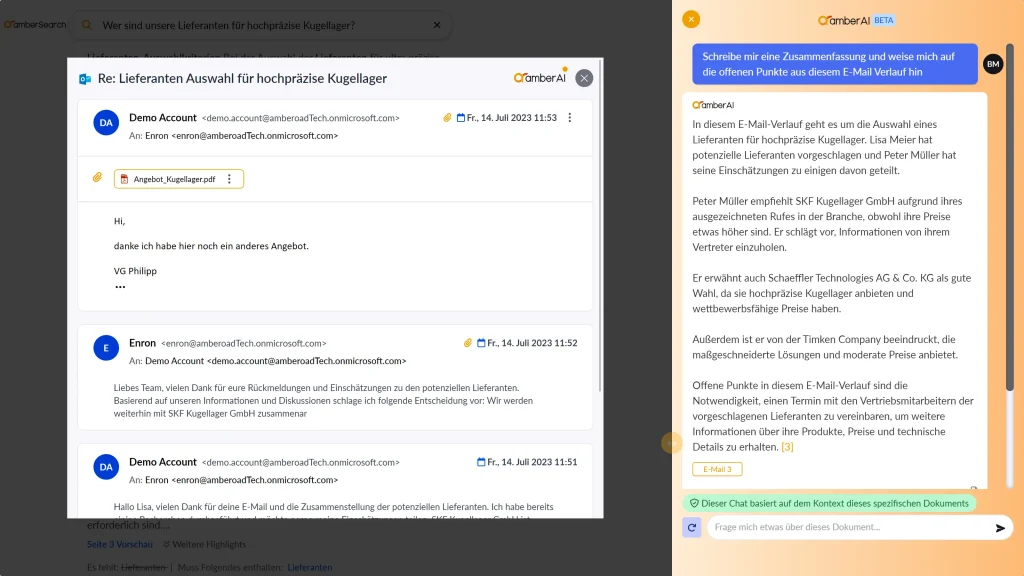

Screenshots der Ergebnisse von einigen Anfragen aus unserem systemübergreifenden KI-Assistenten amberAI

Um ein KI-basiertes Assistenzsystem DSGVO-konform einzuführen, müssen einige Voraussetzungen erfüllt sein; bspw. die Berücksichtigung von Zugriffsrechten oder auch ein entsprechendes Hosting. Ein weiterer Vorteil eines entsprechenden Assistenzsystems, insbesondere im Hinblick auf die Nachhaltigkeit, ist, dass man es nicht nachtrainieren muss. Als Technik, um ein solches System umzusetzen wird heutzutage daher auf Retrieval Augmented Generation gesetzt. Der verlinkte Blogartikel erklärt die Funktionsweise von amberAI. Damit kann amberSearch ohne das Training eines kundenspezifischen KI-Modells entsprechenden Assistenten zur Verfügung stellen.

Damit jeder amberSearch einmal ausprobieren kann, haben wir in unserer Onlinedemo eine mittlere sechsstellige Anzahl an Dokumenten auf über 10 Systeme verteilt:

Dadurch, dass bei Retrieval Augmented Generation der Prozess 2-stufig (Zunächst rechtebasierte Suche in einem Index, anschließend kontextbasierte Generierung einer Antwort), können die oben genannten Anforderungen erfüllt werden und es kann auf das Training eines eigenen KI-Modells verzichtet werden. Dies macht den Einsatz von generativer KI deutlich nachhaltiger, da andernfalls ein eigenes KI-Modell ständig aktualisiert werden müsste (s. Blogbeitrag über selbsttrainierte KI-Modelle).

Veranschaulichung, wie ein KI-basierter Assistent übergreifend implementiert werden könnte

Wie wird ein systemübergreifendes KI-basiertes Assistenzsystem implementiert?

Bei amberSearch haben wir unsere Enterprise Search amberSearch als Grundlage für unseren Assistenten amberAI genommen. Dieser ermöglicht uns über Standardkonnektoren, die Verbindung zu den verschiedenen IT-Systemen des Unternehmens (bspw. M365, Atlassian, Netzwerklaufwerke, d.velop & Co) herzustellen und während des Suchprozesses die vorhandenen Zugriffsrechte zu berücksichtigen. Da wir wissen, dass die IT-Ressourcen bei unseren Kunden begrenzt sind, ist amberSearch bzw. amberAI so konstruiert, dass die Lösung mit minimalem Aufwand (<0,5 Tage) mit Hilfe implementiert werden kann. Aus technischer Sicht inkludiert dies einerseits die Integration von anderen Systemen in amberAI, andererseits aber auch von amberAI in die operativen Systeme. Eine spannende Erkenntnis, die wir bei amberSearch haben: Ein KI-basiertes Assistenzsystem wird von Mitarbeitern nur genutzt, wenn er nahtlos in die bestehenden Systeme integriert ist. Daher haben wir bei amberSearch diverse Möglichkeiten für unsere Nutzer geschaffen, um amberAI nutzen zu können:

- Webapp

- Teamsapp

- Desktopapp

- Mobile Optimierung

- Iframe für alle Iframefähigen-Systeme

- Chromeplugin

- ….

Bei der Auswahl eines übergreifenden KI-basierten Assistenzsystems ist darauf zu achten, dass es sowohl in die IT-Systeme integriert werden kann als auch eine bessere Verfügbarkeit in den bestehenden IT-Systemen ermöglicht. Ergänzend dazu haben wir einen Blogartikel geschrieben, der sich explizit mit diesem Thema beschäftigt.

Wie viel Aufwand ist die Integration eines übergreifenden KI-Assistenten?

Der konkrete Implementationsaufwand hängt immer von den spezifischen Gegebenheiten ab. Aber wenn amberAI als Managed Service gehostet werden soll, dann müssen für Onlinesysteme Appregistrationen und für On-Premise Systeme ein VPN in Verbindungen mit Serviceaccounts aufgesetzt werden. Der technische Aufwand zur Implementation beträgt somit weniger als <0,5 Tage. Von außen können wir jedoch schlecht einsehen, wie aufwendig die Freigabeprozesse gestaltet sind, damit ein IT-Administrator die entsprechenden Schritte durchführen darf. Wer sich mit dieser Technologie beschäftigt, der sollte ein grundlegendes Verständnis der Technologie haben, damit die Erwartungen umsetzbar sind.

Wer überlegt, solche Technologien in seinem Unternehmen einzusetzen, der sollte vorher unser kostenloses, 16-seitiges White Paper mit allen notwendigen Insights lesen: „So geht eine erfolgreiche Einführung von generativer KI“:

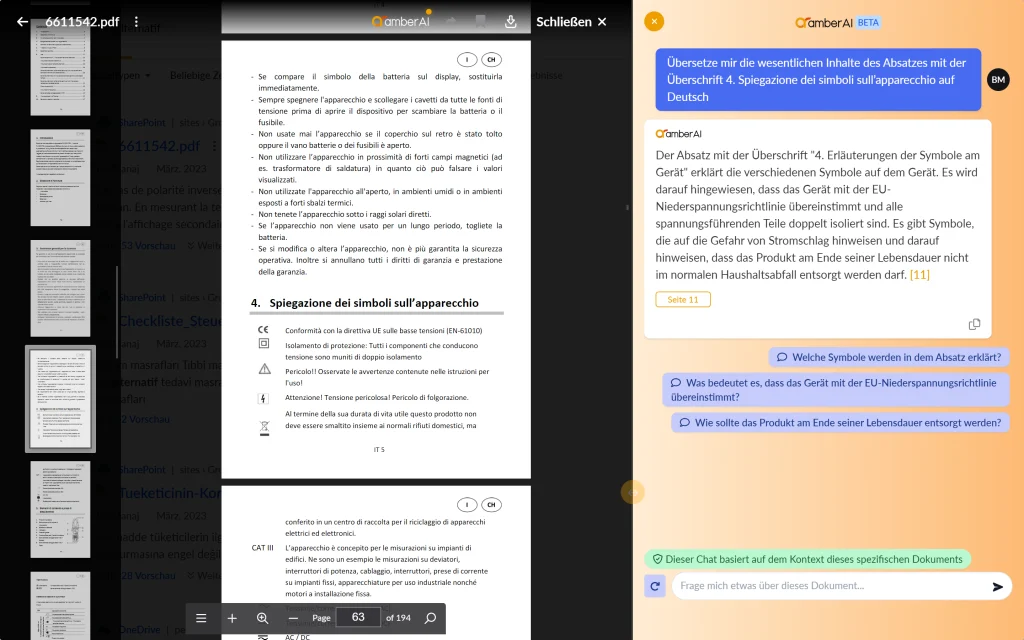

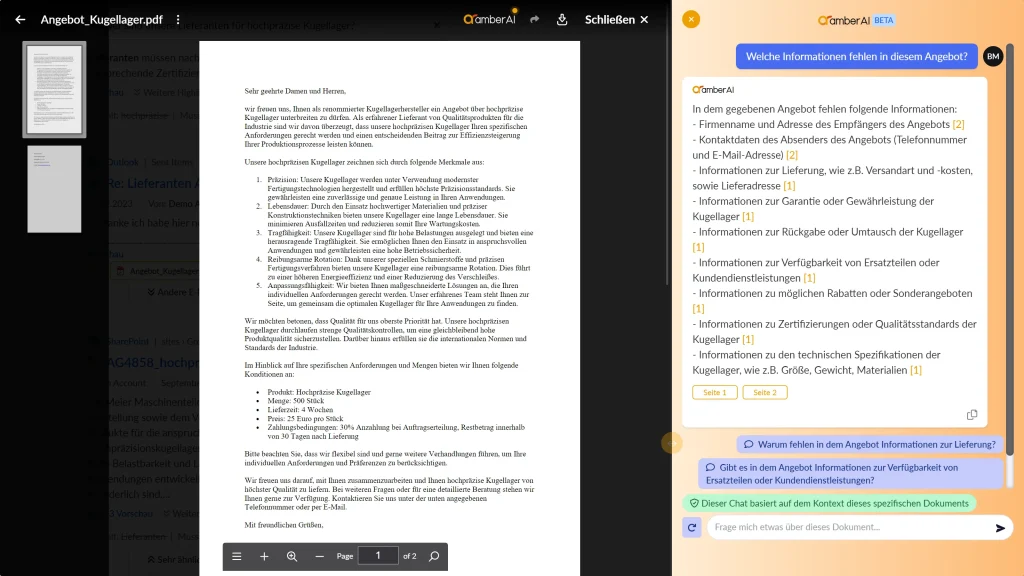

Mit Dokumenten chatten

Die systemübergreifende Verwendung solcher Systeme ist ein Anwendungsfall von KI-basierten Assistenzsystemen. Ein weiterer extrem großer Mehrwert ist auch das Chatten mit Dokumenten bzw. unternehmensinternen Inhalten. Bietet ein Assistenzsystem diese Mehrwerte nicht, werden die Mitarbeiter dazu übergehen, irgendwelche, von der IT nicht freigegeben Onlinetools zu nutzen, um sich Zusammenfassungen oder Analysen zu Dokumenten erstellen zu lassen. Darum ist ein gutes KI-basiertes Assistenzsystem auch in der Lage, solche Anwendungsfälle zu lösen:

Screenshots aus dem Dokumentenchat aus unserer KI amberAI

amberAI ausprobieren

Um unsere Überzeugungen zu verdeutlichen, setzen wir bei amberSearch auf die Devise ‚Zeigen statt erzählen‘. Aus diesem Grund haben wir ein umfangreiches Demosystem entwickelt, das über 10 angebundene Systeme (Laufwerke, M365, Atlassian, d.velop & Co) umfasst. Dadurch kann jeder den Mehrwert unserer Lösung direkt erleben. Dies ist der Link zum Demosystem.

amberAI vs. Microsoft Copilot

Viele Unternehmen nutzen verschiedene Microsoftprodukte und überlegen daher, ob sie den Microsoft Copilot als mögliche Investition betrachten. Doch Microsoft macht es Kunden (Stand Q4 2023) nicht gerade einfach, den Copiloten zu nutzen. Aus diesem Grund haben wir uns die Zeit genommen, um uns in diesem Blogartikel explizit gegenüber dem Copiloten von Microsoft zu positionieren.

Du findest unseren Content spannend?

Dann bleib jetzt über unseren Newsletter mit uns in Kontakt: